Qu'est-ce qu'Apache Airflow ?

Apache Airflow est un outil open source conçu pour automatiser, planifier et superviser des workflows (enchaînements de tâches). Concrètement, il permet de coordonner les différentes étapes d’un processus métier ou data, comme l’extraction de données, leur traitement, puis la génération de rapports ou l’entraînement de modèles de machine learning.

Qu'est-ce qu'Apache Airflow ?

Apache Airflow est un outil open source conçu pour automatiser, planifier et superviser des workflows (enchaînements de tâches). Concrètement, il permet de coordonner les différentes étapes d'un processus métier ou data, comme l'extraction de données, leur traitement, puis la génération de rapports ou l'entraînement de modèles de machine learning.

Pourquoi utiliser Apache Airflow ?

Avec l'explosion des volumes de données, la multiplication des traitements sur les données, que ce soit sur l'extraction, la transformation ou le chargement, il est nécessaire de piloter de manière fiable et centraliser les flux de données dans l'entreprise. C'est le rôle d'Apache Airflow : donner une vision globale sur les flux, leur orchestration, leur état, tout en laissant une liberté totale sur ce qu'ils font.

Apache Airflow s'adapte à tout type de tache car c'est un orchestrateur, sa mission est de planifier, d'exécuter, et reporter. En cela, Apache Airflow n'est pas un ETL ! Mais il saura très bien s'accomoder de ce rôle si vous êtes en mesure d'effectuer les transformations en Python ou avec tout autre outil qu'Airflow est capable de lancer. Et Airflow est capable de tout lancer à partir du moment où il peut lancer des conteneurs Docker pour exécuter ses taches !

Pourquoi choisir Apache Airflow ?

Apache Airflow est une solution fiable, scalable, et automatisée qui permet de gagner du temps en réduisant les interventions manuelles sur le suivi des flux. Apache Airflow propose une vision claire des enchainements des flux, avec une timeline précise, une carte d'état des flux, une gestion efficace des erreurs et de l'alerting.

Comment installer Apache Airflow ? Un des avantages d'Apache Airflow est d'être supporté par les principaux CloudLe Cloud consiste à accéder à des ressources informatiques, à partir d'internet, via un fournisseur. provider public :

- Apache Airflow est présent dans Azure Fabric sur Azure

- Apache Airflow est présent en service managé (MWAA) sur AWS

- Apache Airflow s'installe sur votre Cluster Kubernetes via des Chart Helm déjà tout prêt

- ou vous pouvez également utiliser directement les conteneurs Docker proposés.

Vous avez donc un grand choix d'installation d'Apache Airflow que vous soyez hébergé On Premise ou sur un Cloud, que vous soyez capable d'assumer sa mise à jour ou que vous la deleguiez à votre Cloud Provider préféré.

Qui utilise Apache Airflow ?

Airflow a été initialement développé en 2014 par Airbnb, pour répondre à un besoin croissant : organiser et fiabiliser leurs pipelines de données. Le projet a rapidement gagné en maturité et a été adopté par de nombreuses entreprises tech. Il est devenu un projet de la Apache Software Foundation en 2019, ce qui garantit une gouvernance ouverte, une évolution continue et une large communauté d'utilisateurs et de contributeurs.

Apache Airflow est désormais utilisé par les entreprises, de la startup à la multinationale. Parmi les utilisateurs d'Apache Airflow, on peut compter Airbnb bien sûr, Netflix, Slack, Adobe…

Apache Airflow est-il scalable ?

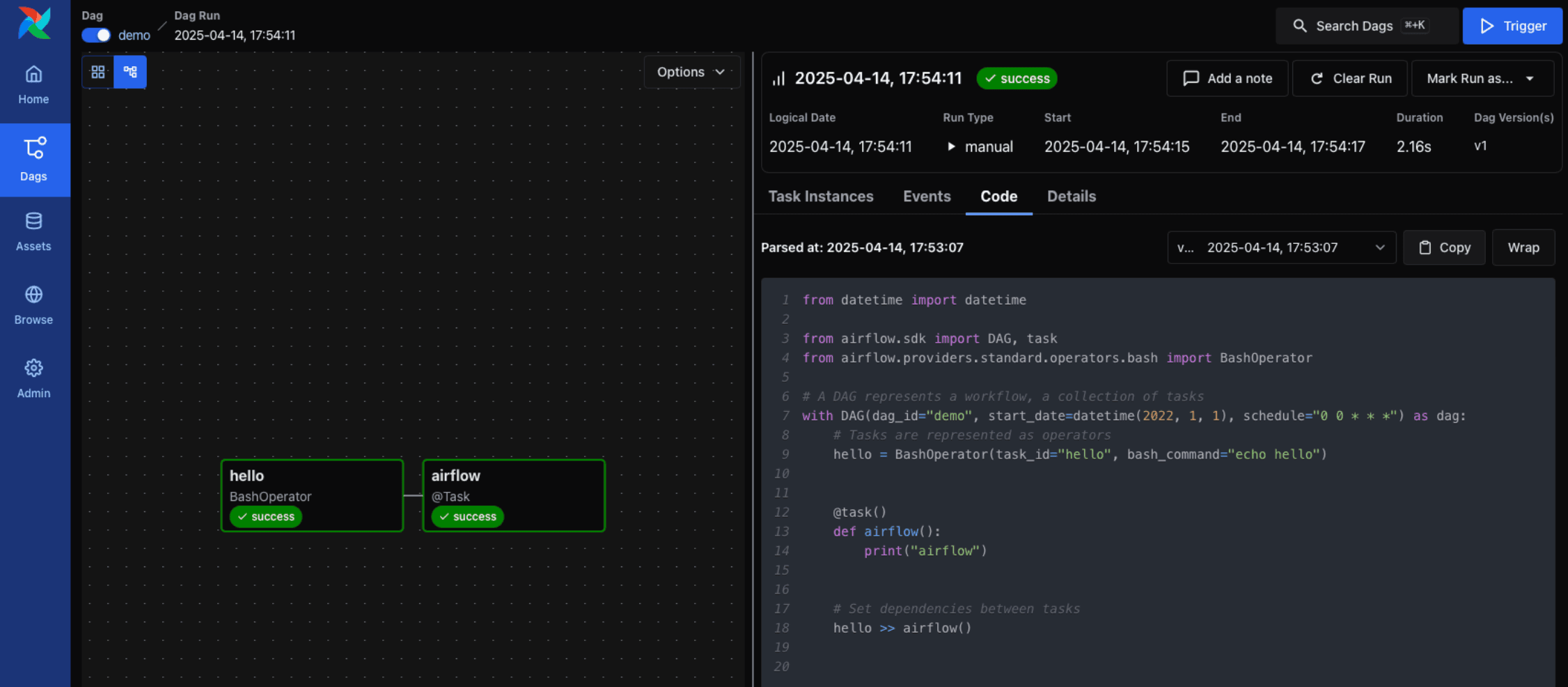

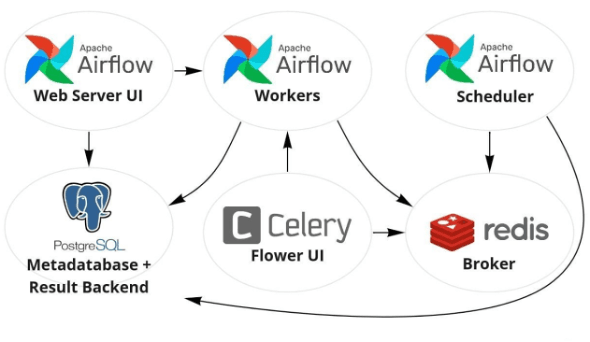

La réponse est un grand OUI ! Apache Airflow est conçu pour supporter des charges de plusieurs milliers de DAG ( pour « Directed Acyclic Graph » : le nom d'un flux pour Airflow). Son architecture est composé de trois briques distinctes :

- Un webserver : c'est l'interface graphique pour consulter Airflow

- Un ou plusieurs scheduler : ils permettent de programmer l'exécution des flux

- Des runners : ce sont eux les bosseurs ! ils s'emploient à exécuter la charge de travail !

Expertise Apache Airflow à Lyon

Vous envisagez d'utiliser Apache Airflow pour remplacer un outil existant, ou parce que vous avez désormais besoin de mieux industrialiser vos flux. Nous pouvons vous aider :

· Conseil et recommandations autour de l'utilisation d'Airflow

· Mise en place de l'infrastructure Airflow et bonnes pratiques

· Développement de DAG Airflow

· AuditUn audit consiste à réaliser un état des lieux critique d'une application en fonction des objectifs fixés. de développements Airflow

· Etude de migration vers Airflow

Nos podcasts en lien

Pour aller plus loin

JAVA 8 – Map – ComputeIfPresent pour la gestion des caches

Un besoin récurrent en Java 8 est la mise à jour des données à l’intérieur du cache : on veut alors modifier une valeur pour une clé existant dans la Map. C’est à ça que sert la méthode computeIfPresent.

4 bonnes pratiques pour une transformation digitale ETI réussie

Lorsque l’on souhaite se lancer dans une transformation digitale en tant qu’ETI, il y a plein de paramètres à prendre en compte pour une transformation digitale ETI réussie : la stratégie, l’organisation, la technique, la mobilisation des équipes, etc. ! Après avoir eu l’occasion d’accompagner plusieurs ETI sur ce sujet, nous avons pu vivre des stratégies et des histoires différentes, et donc, dégager des enseignements croisés pour faire mieux. A nos yeux, justement, l’un des points fondamentaux pour faire de votre transformation digitale ETI une réussite est de faire adhérer les équipes à des valeurs communes. Nous avons donc dégagé 4 valeurs à diffuser au sein de votre entreprise que nous avons le plaisir de vous partager dans cet article.

Les réunions en visio

Découvrez la planche #21 !